2025. 1. 2. 20:13ㆍ선형시스템이론

교재 : Linear System Theory and Design 4th Ed. by Chen, Oxford, 2013

Vector space

스칼라 필드 K(실수or복소수)에 대한 Vector space V

Definition : V 는 공집합이 아니며

1. Vector Addition : for any u, v∈V, a sum u+v∈V

2. Scalar Multiplication : any u∈V, k∈K, a product ku∈V

u, v, w∈V : vector space에 있는 element를 vector 라고 부른다.

8가지 공리를 만족

1. (u+v)+w=u+(v+w) : 결합 법칙, associativity

2. for any u∈V, zero vector, 영벡터

u+0=0+u=u

3. for each u∈V, negative of u, −u

u+(−u)=(−u)+u=0

4. u+v=v+u

5. for any scalar k∈K, k(u+v)=ku+kv, 분배 법칙

6. for any scalars a, b∈K, (a+b)u=au+bu

7. for any scalars a, b∈K, (ab)u=a(bu)

8. for the unit scalar 1∈K, 1u=u

Vector space의 예시

1. 유클리드 공간 Euclidean space

definition : 유클리드 공간은 Rn 으로 정의되는 특정한 vector space로, 다음과 같은 추가적인 구조가 정의된 공간

- 내적 : 두 벡터간 내적 u⋅v가 정의됨.

이를 통해 벡터의 크기(길이)와 각도를 계산할 수 있음

- 거리와 크기 : 벡터의 크기 norm은 ‖v‖=√v⋅v

두 벡터 사이의 거리, 유클리디안 거리 d(u,v)=‖u−v‖

- 예시 : R2 : 2차원 평면 공간, x-y좌표

R3 : 3차원 평면 공간. x-y-z 좌표

space Kn, 즉 K가 실수라면 Rn은 유클리디안 공간이고 이는 vector space 이다.

vector addition과 scalar multiplication을 각각의 space에 대해 정의해야 한다.

vector addition : (a1,a2,⋯,an)+(b1,b2,⋯.bn)=(a1+b1.a2+b2,⋯,an+bn)

scalar multiplication : k(a1,a2,⋯,an)=(ka1,ka2,⋯,kan)

2. Polynomial space Pn(t)

스칼라 필드 K에 대한 모든 다항식 p(t)의 집합 Pn(t) 는 차수가 n이하인 모든 다항식

P(t)=a0+a1t+a2t2+⋯+asts

vector addition, scalar multiplication은 다항식에 대해 성립

3. Matrix space Mm,n

스칼라 필드 K에 대한 모든 mxn matrix들의 집합

vector addition, scalar multiplication 성립

4. Function space F(X)

다항식을 비롯한 모든 함수가 포함됨

vector addition, scalar multiplication 성립

Linear Dependence and Independence 선형 의존, 선형 독립

definition : 만약 scalar a1,a2,⋯,am 이 K에서 존재하고,

a1v1+a2v2+⋯+amvm=0 only when a1=a2=⋯=0이라면

vectors v1,v2.⋯,vm in V 는 linearly independenet 하다.

그게 아니면, linearly dependent 하다.

Linear Combination 선형 조합

V는 스칼라장 K에 대한 vector space 이고, vector v in V is a linear combination of vectors u1,u2,⋯,um in V if there exist scalars a1,a2,⋯,am in K such that

v=a1u1+a2u2+⋯+amum

Spanning Sets 생성 집합

모든 가능한 linear combination

given u1,u2,span{u1,u2}={au1+bu2|a,b∈K}

Subspaces 부분 공간

subspace = subset of vector spaces, 또한 그것 자체도 vector space

모든 subspace는 원점을 지나야 한다!

예) vector space V=R2

subset A : scalar multiplication 이 안됨, 영벡터가 포함 안됨

A는 V의 subspace가 아니고, vector space가 아니다.

subset C : 직선

vector addition, scalar multiplication 이 가능해 vector space이고, V=R2의 subspace 이다.

V의 subspace들의 합집합은 V의 subspace가 아니고, 교집합은 subspace가 맞다.

행렬 A에 대한 row space : 행렬 A의 row의 linear combination으로 만들 수 있는 모든 집합. span{rows}

Let A=[2−10210011]

우선 A를 echelon form으로 변환해야 한다.

L2 = L2 - L1

A = [2−10020011]

L3 = 2*L3-L2

A = [2−10020002]

row space of A = span{ (2−10),(020),(002) }

만약 행렬 A의 row vector 들이 서로 linearly independent이면 row space의 basis가 된다.

행렬의 Row Space를 구성할 때, 각 행rowvector이 꼭 선형 독립일 필요는 없습니다. 하지만, Row Space의 **기저basis**를 구성하는 벡터들은 반드시 선형 독립이어야 합니다.

행렬 A에 대한 column space

AT=[220−111001]

L2 = L1 + 2*L2

AT=[220042001]

column space of A = span{ (220),(042),(001) }

A의 row vector를 span한 row space는, A를 전치한 AT의 column vector를 span한 column space와 같다.

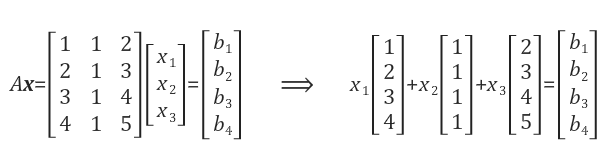

Ax=b 는 모든 b 에 대해 해를 가지고 있을까?

예를 들어 b = [0 0 0 0]T 일 때 x = [0 0 0]T 가 된다.

또한 b=[1 2 3 4]T 일 때 x=[1 0 0]T이 된다. 이때 b는 A의 첫 번째 열과 같다.

우리는 선형 방정식 Ax=b에 대해 b벡터가 A의 column space에 존재할 때만 해를 구할 수 있다.

즉, b벡터가 A의 column의 linear combination으로 표현이 가능할 때 Ax=b에 대한 해를 구할 수 있다.

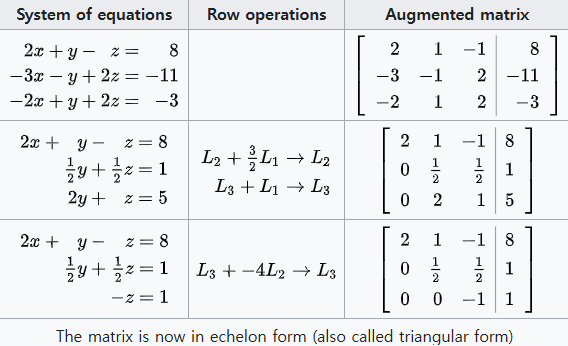

Gauss Elimination 가우스 소거법

gauss elimination, 즉 row reduction이란, 연립일차방정식을 풀이하는 알고리즘이다. 풀이 과정에서, 일부 미지수가 차츰 소거되어 결국 남은 미지수에 대한 linear combination으로 표현되면서 풀이가 완성된다.

row operations

1. 두 행을 바꾼다

2, 한 행에 0이 아닌 스칼라를 곱한다

3. 한 행에 스칼라를 곱하고 다른 행으로 더한다.

echelon : 계급, 계층, 지위

in echelon : 사다리꼴을 이루어

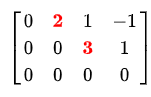

row echelon form 행사다리꼴 행렬 은 gauss elimination의 결과로 얻어지는 행렬이다.

조건 1. 0으로만 이루어진 행이 존재할 경우에 그 행은 행렬의 마지막 행이다.

2. 모든 0이 아닌 행의 pivot , 즉 leading coefficient 선행계수는 항상 그 위 행의 선행계수의 오른쪽에 있다.

* 만약 이때 모든 pivot이 1이면 reduced row echelon form 이다.

row reduction 절차 : 1행 밑에서 x를 제거한다, 그 후 2행 밑에서 y를 제거한다.

시스템을 triangular form으로 만든 이후 back substitution을 통해 각각의 미지수를 푼다.

Basis and Dimension

basis 기저

definition : A set S=u1,u2,⋯,un of vectors is a basis of V if it has the following two properties :

1. S is linearly independent, 최소한의 개수

2. S spans V

dimension 차원 : 벡터 공간에서 차원은 선형 독립 벡터들로 이루어진 basis의 개수 로 정의된다.

즉, 차원은 벡터 공간을 생성 span 하는 데 필요한 최소한의 벡터 수 이다.

단일 벡터 자체에는 차원이 정의되지 않는다.

하지만 단일 벡터 v≠0로 생성된 벡터 공간의 차원은 1이다.

단일 벡터가 영벡터라면, 생성된 벡터 공간의 차원은 0이다.

vector space M2,3 의 경우 basis :

[100000],[010000],[001000],[000100],[000010],[000001]

차원 dimM2,3=2×3=6

vector space Pn(t) of all polynomials of degree ≤n 의 경우

n+1차 polynomial의 set S = {1,t,t2,t3,⋯,tn} 가 basis

차원 dimPn(t)=n+1

Rank of matrics

definition : The rank of a matrix A, written rankA, is equal to the maximum number of linearly independent rows/columns of A

rank(A)=rank(AT)

A=[122330]

−6(32L1−L2)=L3, L1과 L2는 linearly independent

rank(A)=2

B=[110220330]

rank(B)=1, 최소 rank는 1이다.

matrix를 row reduction form으로 만들면 pivot column의 개수가 그 matrix의 rank 이다.

A=[122330]

L2 = L2-2*L1 하면

RREF(A)=[120−130]

L3=L3-3*L1하면

RREF(A)=[120−10−6]

L3=L3-6*L2하면

RREF(A)=>[120−100]

RREPA에 2개의 pivot column이 있으므로 A의 rank는 2이다.

A "pivot column" in a matrix is

a column that contains a "pivot element", which is the leading non-zero entry in a row when the matrix is in row echelon form

Sums and direct sums

sum

U+W = {v : v = u+w, where u∈U and w∈W }

U와 W는 V의 subspace이면, U+W 도 V의 subspace이다.

dim(U+W)=dimU+dimW−dim(U∩W)

U=1,2,W=3,4 이면 U+W=1+2,1+3,2+3,2+4,U∪W=1,2,3,4

direct sum

vector space V는 V의 subspace U와 W의 direct sum 이다. V=U⊕W 오직 다음 두 조건을 만족할 때 :

1. V=U+W

2. U∩W=0

영벡터는 모든 vector space의 필수적 구성 요소로, 공간의 독립성을 깨지 않는다.

Coordinates 좌표

V가 basis S=u1,u2,⋯,un인 n-dimensional vector space라 하자.

그러면 any vector v∈V는 basis vector S의 linear combination으로써 유일하게 표현될 수 있다.

v=a1u1+a2u2+⋯+anun

이런 n개의 scalar a1,a2,⋯,an을 vector v의 basis S에 상대적인 coordinates 라고 한다. 주로 열벡터로 표현된다.

'선형시스템이론' 카테고리의 다른 글

| phase plane vs phase portrait 0 | 2025.02.06 |

|---|---|

| Diagonalization : Eigenvalues and Eigenvectors 0 | 2025.01.31 |

| Inner Product Spaces, Orthogonality 0 | 2025.01.20 |

| Linear Mappings and Matrices 0 | 2025.01.07 |

| Linear Mappings 0 | 2025.01.05 |